Apa File Robots.txt dalam Domain?

Alat Webmaster Situs Web Seo Pahlawan / / March 19, 2020

Terakhir diperbarui saat

Salah satu kesalahan terbesar bagi pemilik situs web baru adalah tidak melihat ke file robots.txt mereka. Jadi, apa masalahnya, dan mengapa begitu penting? Kami punya jawaban Anda.

Jika Anda memiliki situs web dan peduli dengan kesehatan SEO situs Anda, Anda harus membuat diri Anda terbiasa dengan file robots.txt di domain Anda. Percaya atau tidak, itu adalah sejumlah besar orang yang dengan cepat meluncurkan domain, menginstal situs web WordPress yang cepat, dan tidak pernah repot melakukan apa pun dengan file robots.txt mereka.

Ini berbahaya. File robots.txt yang tidak terkonfigurasi benar-benar dapat menghancurkan kesehatan SEO situs Anda, dan merusak peluang yang mungkin Anda miliki untuk meningkatkan traffic Anda.

Apa itu File Robots.txt?

Itu Robots.txt file dinamai dengan tepat karena pada dasarnya itu adalah file yang mencantumkan arahan untuk robot web (seperti robot mesin pencari) tentang bagaimana dan apa yang dapat mereka perayapi di situs web Anda. Ini telah menjadi standar web yang diikuti oleh situs web sejak 1994 dan semua perayap web utama mematuhi standar tersebut.

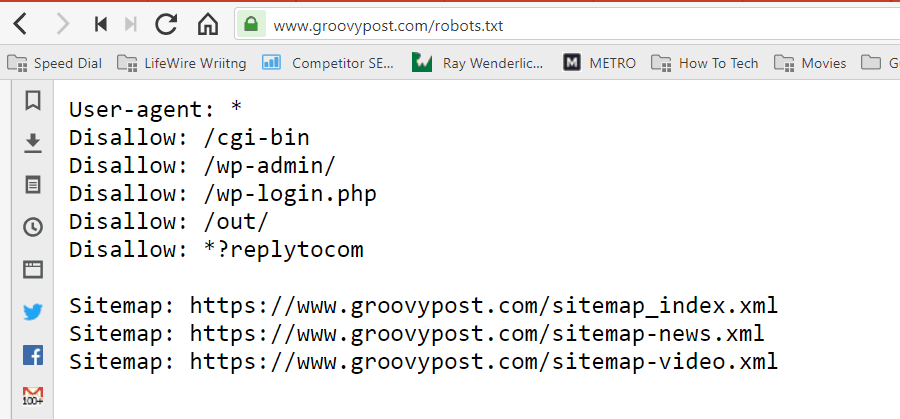

File disimpan dalam format teks (dengan ekstensi .txt) pada folder root situs web Anda. Faktanya, Anda dapat melihat file robot.txt situs web apa pun hanya dengan mengetikkan domain diikuti oleh /robots.txt. Jika Anda mencoba ini dengan groovyPost, Anda akan melihat contoh file robot.txt terstruktur dengan baik.

File ini sederhana namun efektif. File contoh ini tidak membedakan antara robot. Perintah dikeluarkan untuk semua robot dengan menggunakan Agen pengguna: * pengarahan. Ini berarti bahwa semua perintah yang mengikutinya berlaku untuk semua robot yang mengunjungi situs untuk menjelajahinya.

Menentukan Perayap Web

Anda juga bisa menentukan aturan khusus untuk perayap web tertentu. Misalnya, Anda mungkin mengizinkan Googlebot (perayap web Google) untuk merayapi semua artikel di situs Anda, tetapi Anda mungkin ingin larang perayap web Rusia Yandex Bot dari merayapi artikel di situs Anda yang memiliki informasi meremehkan Rusia.

Ada ratusan perayap web yang menjelajahi internet untuk mendapatkan informasi tentang situs web, tetapi 10 yang paling umum yang harus Anda perhatikan tercantum di sini.

- Googlebot: Mesin pencari Google

- Bingbot: Mesin pencari Microsoft Bing

- Mencucup: Mesin pencari Yahoo

- DuckDuckBot: Mesin pencari DuckDuckGo

- Baiduspider: Mesin pencari Baidu Cina

- YandexBot: Mesin pencari Yandex Rusia

- Exabot: Mesin pencari French Exalead

- Facebot: Bot perayapan Facebook

- ia_archiver: Perayap peringkat web Alexa

- MJ12bot: Database pengindeksan tautan besar

Mengambil contoh skenario di atas, jika Anda ingin mengizinkan Googlebot mengindeks semua yang ada di situs Anda, tetapi ingin melakukannya blokir Yandex dari pengindeksan konten artikel berbasis Rusia Anda, Anda akan menambahkan baris berikut ke robots.txt Anda mengajukan.

Agen-pengguna: googlebot

Disallow: Disallow: / wp-admin /

Disallow: /wp-login.php

Agen-pengguna: yandexbot

Disallow: Disallow: / wp-admin /

Disallow: /wp-login.php

Larang: / rusia /

Seperti yang Anda lihat, bagian pertama hanya memblokir Google dari merayapi halaman login WordPress Anda dan halaman administrasi. Bagian kedua memblokir Yandex dari yang sama, tetapi juga dari seluruh area situs Anda tempat Anda menerbitkan artikel dengan konten anti-Rusia.

Ini adalah contoh sederhana tentang bagaimana Anda dapat menggunakan Melarang perintah untuk mengontrol perayap web tertentu yang mengunjungi situs web Anda.

Perintah Robots.txt lainnya

Larang bukan satu-satunya perintah yang dapat Anda akses di file robots.txt Anda. Anda juga dapat menggunakan perintah lain yang akan mengarahkan bagaimana robot dapat merayapi situs Anda.

- Melarang: Memberitahu agen-pengguna untuk menghindari perayapan URL tertentu, atau seluruh bagian situs Anda.

- Mengizinkan: Memungkinkan Anda untuk menyempurnakan halaman atau subfolder tertentu di situs Anda, meskipun Anda mungkin tidak mengizinkan folder induk. Misalnya, Anda dapat melarang: / tentang /, tetapi kemudian mengizinkan: / tentang / ryan /.

- Perayapan-keterlambatan: Ini memberi tahu perayap untuk menunggu beberapa detik sebelum mulai merayapi konten situs.

- Peta Situs: Berikan mesin pencari (Google, Ask, Bing, dan Yahoo) lokasi peta situs XML Anda.

Ingatlah bahwa bot akan melakukannya hanya dengarkan perintah yang Anda berikan saat menentukan nama bot.

Kesalahan umum yang dilakukan orang adalah melarang area seperti / wp-admin / dari semua bot, tetapi kemudian tentukan bagian googlebot dan hanya melarang area lain (seperti / tentang /).

Karena bot hanya mengikuti perintah yang Anda tentukan di bagiannya, Anda harus menyatakan kembali semua perintah lain yang telah Anda tentukan untuk semua bot (menggunakan * agen-pengguna).

- Melarang: Perintah yang digunakan untuk memberi tahu agen pengguna untuk tidak merayapi URL tertentu. Hanya satu baris “Disallow:” yang diizinkan untuk setiap URL.

- Izinkan (Hanya berlaku untuk Googlebot): Perintah untuk memberi tahu Googlebot bahwa ia dapat mengakses halaman atau subfolder meskipun halaman atau subfolder induknya mungkin tidak diizinkan.

- Perayapan-keterlambatan: Berapa detik crawler harus menunggu sebelum memuat dan merangkak konten halaman. Perhatikan bahwa Googlebot tidak mengakui perintah ini, tetapi tingkat perayapan dapat diatur di Google Search Console.

- Peta Situs: Digunakan untuk menyebut lokasi peta situs XML yang terkait dengan URL ini. Perhatikan bahwa perintah ini hanya didukung oleh Google, Ask, Bing, dan Yahoo.

Perlu diingat bahwa robots.txt dimaksudkan untuk membantu bot yang sah (seperti bot mesin pencari) merayapi situs Anda dengan lebih efektif.

Ada banyak perayap jahat di luar sana yang merayapi situs Anda untuk melakukan hal-hal seperti mengikis alamat email atau mencuri konten Anda. Jika Anda ingin mencoba dan menggunakan file robots.txt untuk memblokir perayap tersebut agar tidak merayapi apa pun di situs Anda, jangan repot-repot. Pembuat perayap tersebut biasanya mengabaikan apa pun yang Anda masukkan ke file robots.txt Anda.

Mengapa Tidak Membolehkan Apa Pun?

Membuat mesin pencari Google merayapi sebanyak mungkin konten berkualitas di situs web Anda adalah perhatian utama bagi sebagian besar pemilik situs web.

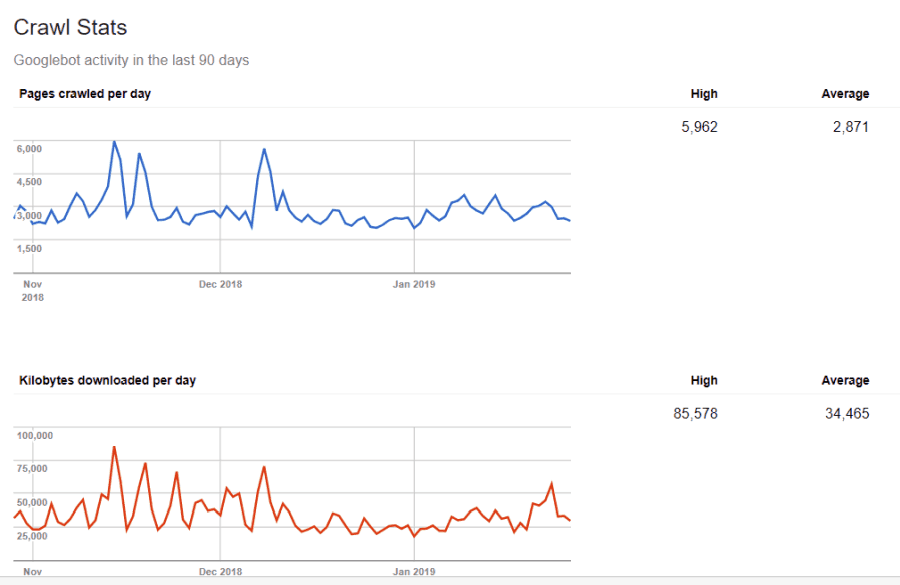

Namun, Google hanya mengeluarkan biaya terbatas anggaran jelajah dan tingkat perayapan di situs individu. Tingkat perayapan adalah berapa banyak permintaan per detik Googlebot akan membuat ke situs Anda selama acara perayapan.

Yang lebih penting adalah anggaran perayapan, yaitu berapa banyak total permintaan yang akan dibuat Googlebot untuk merayapi situs Anda dalam satu sesi. Google “menghabiskan” anggaran perayapannya dengan berfokus pada area situs Anda yang sangat populer atau telah berubah baru-baru ini.

Anda tidak buta terhadap informasi ini. Jika Anda berkunjung Alat Webmaster Google, Anda dapat melihat bagaimana perayap menangani situs Anda.

Seperti yang Anda lihat, perayap menjaga aktivitasnya di situs Anda cukup konstan setiap hari. Itu tidak merayapi semua situs, tetapi hanya yang dianggap paling penting.

Mengapa menyerahkan kepada Googlebot untuk memutuskan apa yang penting di situs Anda, ketika Anda dapat menggunakan file robots.txt untuk memberi tahu halaman apa yang paling penting itu? Ini akan mencegah Googlebot dari membuang waktu pada halaman bernilai rendah di situs Anda.

Mengoptimalkan Anggaran Perayapan Anda

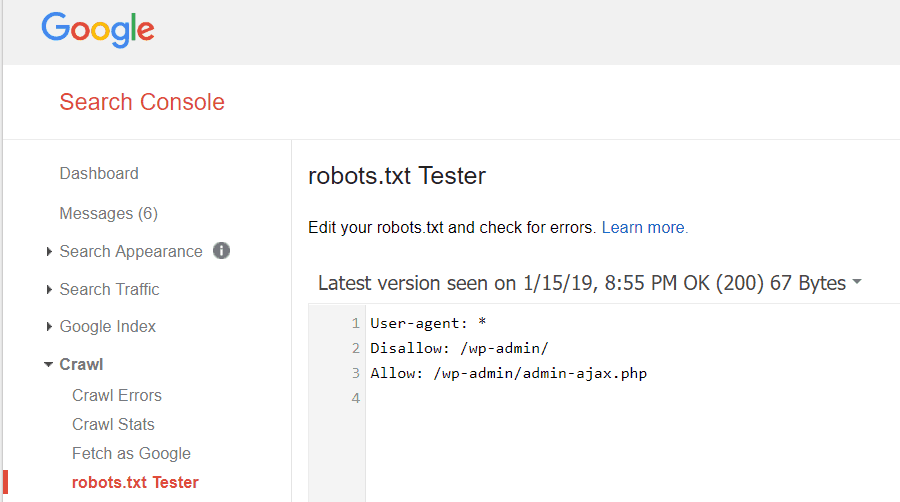

Google Webmaster Tools juga memungkinkan Anda memeriksa apakah Googlebot membaca file robots.txt Anda dengan baik dan apakah ada kesalahan.

Ini membantu Anda memverifikasi bahwa Anda telah menyusun file robots.txt dengan benar.

Halaman apa yang harus Anda batalkan dari Googlebot? Baik untuk SEO situs Anda untuk melarang kategori halaman berikut.

- Halaman duplikat (seperti halaman ramah-printer)

- Halaman terima kasih mengikuti pesanan berbasis formulir

- Formulir pemesanan atau kueri informasi

- Halaman kontak

- Halaman login

- Halaman “penjualan” magnet timbal

Jangan Abaikan File Robots.txt Anda

Kesalahan terbesar yang dilakukan pemilik situs web baru adalah tidak pernah melihat file robots.txt mereka. Situasi terburuk bisa jadi file robots.txt sebenarnya memblokir situs Anda, atau area situs Anda, agar tidak dijelajahi sama sekali.

Pastikan untuk meninjau file robots.txt Anda dan memastikannya dioptimalkan. Dengan cara ini, Google dan mesin pencari penting lainnya “melihat” semua hal luar biasa yang Anda tawarkan kepada dunia dengan situs web Anda.